在机器人技术领域,适应复杂环境的操作能力是关键挑战之一。近期,清华大学交叉信息研究院的高阳助理教授及其研究团队提出了名为CoPa(Robotic Manipulation through Spatial Constraints of Parts)的框架,它通过利用基础模型(Foundation Model)中嵌入的常识性知识,极大地提高了机器人在开放世界场景中的操作能力。这一突破性研究成果已在2024年ICRA Workshop上发表,研究组受邀进行Spotlight Talk。

科研成果概要

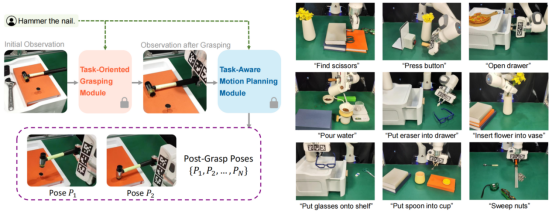

CoPa框架将操纵任务分为两个阶段(如图1左所示):先通过「任务导向的抓取模块(Task-Oriented Grasping)」生成机器人抓取物体的位姿,再通过「任务相关的运动规划模块(Task-Aware Motion Planning)」生成抓取物体后机器人完成任务所需的位姿。

图1:CoPa框架(左)以及CoPa可以完成的复杂操纵任务(右)

CoPa的这两个阶段都依赖于一个核心的「重要部分检测模块(Grounding Module)」。该模块利用了Set-of-Mark(SoM)算法,能够从粗到细地识别出场景中与任务密切相关的物体部件。首先,利用分割模型在较粗的层面上标出场景中的所有物体,然后通过GPT-4V进一步细化,精确地定位到具体的、与任务直接相关的物体部分。

在「任务导向的抓取模块」,CoPa框架利用预训练的抓取模型,根据识别的抓取对象部位生成最佳抓取位姿。在「任务相关的运动规划模块」,CoPa框架利用GPT-4V生成完成任务需要满足的空间几何约束,再基于这些约束求解出一系列后续位姿,最后通过运动规划算法精确执行。

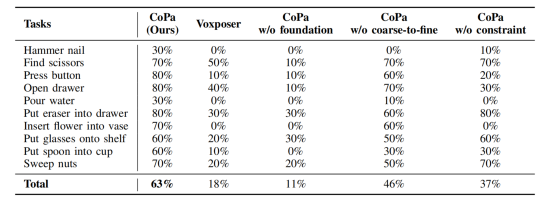

表1:CoPa与各种基线算法的对比

充分的现实世界实验展现了CoPa框架卓越的通用操纵表现。实验中,CoPa在各种日常操控任务(如图1右所示)中表现出高达63%的成功率,显著优于现有的方法(如表1所示)。这些任务包括从简单的“放置物体”到更复杂的“操作工具”等,充分展示了CoPa在处理多变环境和未知指令时的强大能力。

同时,得益于重要部分检测模块以及空间几何约束的巧妙设计,CoPa框架不仅很大程度上减少了对复杂提示工程的依赖,还在实验中展现出了对任务以及场景的细致物理理解(如“锤钉子”时锤头需要正对钉面,“插花”时花需要竖直插入花瓶等等)。

CoPa不仅能处理简单的操控任务,还可以与长程规划算法ViLa结合,执行更为复杂的操作序列。例如,上面两个视频展示了在制作手冲咖啡或布置浪漫餐桌任务中,CoPa能够准确地执行高级规划算法划分的各个步骤,体现了其在实际应用中的巨大潜力。

随着机器人技术的不断进步,CoPa框架的提出为机器人的广泛应用开辟了新的道路。无论是工业生产线上的精密操作,还是日常环境中的服务机器人,CoPa的高度适应性和强大的场景理解能力都预示着其广阔的应用前景。此外,随着算法的进一步完善和优化,预期CoPa将在未来的机器人研究和应用中发挥更加关键的作用。

CoPa优异的表现受到了众多机器人领域大佬的高度评价。ICRA国际会议审稿评价其为“一个非常完备的集成框架”。IBM前CTO和Quebec AI等多位大佬纷纷点赞转发。此外,SoM算法的作者高度赞赏CoPa为“Great Work”,是将基础模型的能力与机器人领域相结合的优秀框架。

该论文CoPa: General Robotic Manipulation through Spatial Constraints of Parts with Foundation Models来自清华大学交叉信息院高阳研究组。论文共同第一作者为清华大学交叉信息研究院预研生黄浩栩、清华大学交叉信息研究院预研生林凡淇,通讯作者为高阳助理教授,其他作者还包括2021级博士生胡英东、2023级博士生王圣杰。

论文链接:https://arxiv.org/abs/2403.08248

编辑 | 姜月亮

审核 | 吕厦敏