近日,深度学习领域顶级会议International Conference on Learning Representations(ICLR,国际表征学习大会)公布了2020年论文录用情况,交叉信息院共11篇论文被大会接收,其中5篇(5人次)来自交叉信息院研究生,6篇(5人次)来自计算机科学实验班(姚班)计科60。

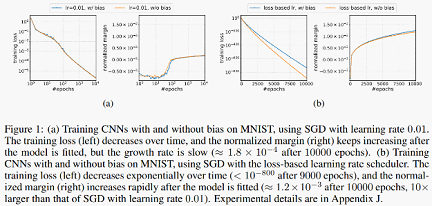

图自论文《梯度下降可最大化齐次神经网络的分类间隔》(吕凯风,李建)

2018级硕士生王同翰、2019级博士生王鉴浩、2015级博士生朱广翔、2019级硕士生骆轩源和2019级博士生吕凯风发表的5篇论文中,研究内容涵盖多智能体强化学习中的探索-利用困境、可扩展多智能体学习的值函数分解、深度强化学习的样本效率、深度学习中梯度算法的泛化误差界、以及深度学习中梯度算法的隐式偏好等问题。其中,由我院李建副教授指导吕凯风共同完成的论文《梯度下降可最大化齐次神经网络的分类间隔》为口头报告论文(Talk);由我院张崇洁助理教授指导王同翰和王鉴浩共同完成的论文《基于相互影响的多智能体协作探索》为大会亮点论文(Spotlight)。

王远皓、董克凡、张天纵、王蕴韵和邹岳松5名计科60同学累计发表的6篇论文中,研究内容涵盖强化学习中免模型算法的高采样效率、分布式老虎机任务中的悔恨值最小化的问题、局部求解最小最大优化问题、神经网络的泛化性能、泛音卷积运算和对超图的特征学习问题等。其中,王远皓同学此次发表3篇一作论文。张天纵合作完成的论文《两层神经网络的渐进泛化分析》入选大会亮点论文(Spotlight)。

ICLR是公认的深度学习领域国际顶级会议之一,关注有关深度学习各个方面的前沿研究。近年来因在人工智能、统计和数据科学领域以及机器视觉、语音识别、文本理解等重要应用领域中发布了众多极其有影响力的论文而广受关注。ICLR采取完全公开评审规则,任何对论文有兴趣的研究者都可以参与到关于论文评审意见的讨论中。这使得ICLR论文评审的透明性和广泛性在深度学习顶会中独树一帜,同时也大大增加了论文被接收的难度。ICLR 2020共有2594篇论文提交,其中48篇被接收为Talk,107篇被接收为Spotlight,532篇作为Poster。

发表论文信息:

1.Gradient Descent Maximizes the Margin of Homogeneous Neural Networks. Kaifeng Lyu, Jian Li. (Talk)

由我院李建副教授指导吕凯风共同完成的论文《梯度下降可最大化齐次神经网络的分类间隔》研究了梯度下降算法在齐次神经网络训练中对不同最优解的隐式偏好。常见的齐次神经网络包括了ReLU激活的全连接或卷积神经网络,分析梯度下降在这类网络上是否会收敛到分类间隔较大的最优解,可以帮助我们更好地理解神经网络的优化及泛化问题。本文的理论分析表明,离散的梯度下降和连续的梯度流在最小化齐次神经网络的逻辑损失或交叉熵损失的过程中,也会逐渐增大标准化分类间隔的一个光滑版变种。经过足够长的训练,标准化分类间隔及其光滑版变种还将收敛到同一极限,并且该极限和一个分类间隔最大化问题的KKT点处值相等。本文的结果极大地推广了前人在线性网络上得到的类似结果;相比于前人在齐次网络上的研究,也在使用的假设更弱的情况下给出了更量化的结果。

2.Influence-Based Multi-Agent Exploration. Tonghan Wang*, Jianhao Wang*,Yi Wu, Chongjie Zhang. (Spotlight)

由我院张崇洁助理教授指导,2018级硕士生王同翰及2019级博士生王鉴浩共同完成的论文《基于相互影响的多智能体协作探索》研究了强化学习中的经典问题:探索-利用困境。多智能体强化学习一直缺少有效的探索策略。该论文首次提出通过激励智能体间相互影响来提高协作探索的框架与方法。作者提出了利用互信息和交互价值来形式化刻画智能体间的相互影响,进一步推导了互信息和交互价值相对于智能体策略的导数,将两者的优化融入到了经典的策略梯度强化学习框架中,得到了简洁的优化公式。该方法揭示了多智能体协作探索与个体内在奖赏分配之间的联系,并在测试集上取得了超过其他算法至少2倍的探索效率。

3.Generalization of Two-Layer Neural Networks: An Asymptotic Viewpoint. Jimmy Ba,Murat Erdogdu, Taiji Suzuki, Denny Wu, Tianzong Zhang. (Spotlight)

由计科60张天纵同学合作完成的论文《两层神经网络的渐进泛化分析》主要聚焦于神经网络的泛化性能。这一问题是现在机器学习领域的重要课题。该论文讨论了渐近意义下两层神经网络的泛化性能问题。特别地,在渐近意义下(即高维、多神经元、多样本,且三者以同一速率趋于无穷时),对于最小二乘的线性回归问题,该论文计算了以不同方法优化(以不同初值优化第一层或第二层)带来的测试误差的准确值,而已有文献一般只给出了误差界。该文章对于研究神经网络中过参数化和初值的作用有一定指导意义。

4.Q-learning with UCB Exploration is Sample Efficient for Infinite-Horizon MDP. Yuanhao Wang, Kefan Dong, Xiaoyu Chen, Liwei Wang. (Poster)

由计科60董克凡、王远皓两位同学在北京大学王立威教授指导下完成的论文《在无限长马尔可夫决策过程中采用UCB探索策略的Q学习算法具有高采样效率》研究了强化学习中的一个基本问题:免模型算法是否具有高采样效率?最近,Jinet al. 提出了采用置信区间上界(UCB)探索策略的Q学习算法,并证明了在有限长马尔可夫决策过程中有接近最优的表现。这篇论文进一步研究了无限长、有折扣奖励、不使用生成模型的马尔科夫决策过程中采用UCB探索的Q学习算法,并证明了该算法的采样效率优于之前的结果,并且是接近最优的。

5.Distributed Bandit Learning: Near-Optimal Regret with Efficient Communication. Yuanhao Wang, Jiachen Hu, Xiaoyu Chen, Liwei Wang. (Poster)

计科60的王远皓同学与合作者完成的论文《分布式老虎机:用高效的通信达到接近最优的悔恨值》研究了在分布式老虎机任务中的悔恨最小化的问题:M个玩家在一个中央服务器协调下合作,希望最小化总体的悔恨值,且以总通信数据量计量的通信开销尽量小。对于分布式K臂老虎机,该论文提出了一个悔恨值接近最优同时通信开销仅有O(Mlog(MK))的协议。这里的通信开销与总时间T无关,与臂的数量只有对数级的依赖,并且与下界只有一个对数因子的差距。对于分布式d维线性老虎机,该论文提出了一个悔恨值接近最优同时通信开销为\Tilde{O}(Md)的协议,其中通信开销对T只有对数级的依赖。

6.On Solving Minimax Optimization Locally: A Follow-the-Ridge Approach. Yuanhao Wang, Guodong Zhang, Jimmy Ba. (Poster)

计科60的王远皓同学与合作者共同完成的论文《局部求解最小最大优化问题:跟随山脊法》在最小最大优化问题上提出了新算法。许多现代的机器学习任务都可以描述成在序贯博弈中寻找均衡的问题。特别地,两人零和序贯博弈,也称为最小最大优化,正受到越来越多的关注。由于梯度下降在有监督学习中获得了成功,将其应用到最小最大优化中是一个很自然的想法。然而,研究者发现简单地应用梯度下降是无法找到某些局部最小最大点的,而且会错误地收敛到非局部最小最大点。这篇文章提出了一个称为跟随山脊法的新算法,并且证明了它收敛且只会收敛到局部最小最大点。他们从理论上证明了该算法能减小梯度方法带来的旋转现象,并且与预条件法和动量法兼容。实验表明,跟随山脊法能解决简单的最小最大问题,还能改进对抗生成网络训练的收敛性。

7.Deep Audio Priors Emerge From Harmonic Convolutional Networks. Zhoutong Zhang, Yunyun Wang, Chuang Gan, Jiajun Wu, Joshua B. Tenenbaum, Antonio Torralba, WilliamT. Freeman. (Poster)

由计科60 王蕴韵同学参与完成的论文《泛音卷积网络产生深度音频先验》提出了适用于音频处理网络的泛音卷积运算,并研究了不同声音架构捕捉深度音频先验的能力。泛音卷积运算充分利用了自然声音中泛音的特性,使得卷积关注在泛音结构而非普通卷积的邻域结构上。相对于传统的音频网络,泛音卷积网络可以更有效地捕捉深度音频先验。在无监督音频还原任务和音源分离任务上,泛音卷积网络也取得了更好的表现。

8.Hyper-SAGNN: a self-attention based graph neural network for hypergraphs.Ruochi Zhang, Yuesong Zou, Jian Ma. (Poster)

由计科60的邹岳松同学参与完成的论文《Hyper-SAGNN:一种基于自注意机制的针对超图的图神经网络》研究了对超图的特征学习问题。超图是一种广义上的图,它的一条边——超边可以连接任意数量的顶点。使用超图能更有效地描述真实世界网络数据,例如论文的共同作者关系。传统方法将超边中元素拆成两两关系或者对超边建立新节点,这样做的同时丢失了信息。亦有直接对超边进行学习的研究,但要求超边大小须统一。该论文提出了一种直接针对超边的基于自注意力特征提取模型,该模型在超边大小不一致时同样有效。同时该论文将点特征提取的node2vec算法推广到了超图,用该方法计算出的点特征初始化模型可以加速收敛。Hyper-SAGNN在准确率上较传统方法和前人的超边学习模型上均有显著提升。此外该模型还可用于离群值鉴定,推测超边中关系与其他顶点较弱的点,这使得它有应用于超图降噪的潜力。

9.Learning Nearly Decomposable Value-Functions via Communication Minimization. Tonghan Wang*, Jianhao Wang*, Chongyi Zheng, Chongjie Zhang. (Poster)

由我院张崇洁助理教授指导,2018级硕士生王同翰及2019级博士生王鉴浩共同完成的论文《学习近似可分解值函数》提出了新颖的基于值函数的多智能体强化学习算法。为了提高多智能体强化学习的可扩展性,该论文首次提出了近似最简可分解值函数结构以及学习方法,解决了传统完全可分解值函数的局限性。该方法通过分析智能体决策过程之间的相互依赖性,动态最大化分解智能体的决策,并学习通过最少信息传递来有效提高多智能体系统的整体协作。在具体实现上,该方法通过最大化传递信息与局部值函数之间的互信息,并最小化信息的熵来构造近似最简可分解值函数结构,并进一步通过推导变分下限使得优化目标变得可计算。在星际争霸2局部战役测试集上,该算法比已有多智能体强化学习算法展现了明显更优的性能,并可以在大多数任务下达到80%以上的值函数分解程度。

10.Episodic Reinforcement Learning with Associative Memory. Guangxiang Zhu*,Zichuan Lin*, Guangwen Yang, Chongjie Zhang. (Poster)

由我院助理教授张崇洁老师指导,我院2015级博士生朱广翔及计算机系2016级博士生林子钏共同完成的论文《基于联想记忆的情景控制强化学习》着眼于提高深度强化学习的样本利用效率。认知学研究发现,人类的高效学习部分源于类似情景控制的学习模式。在日常学习中我们会记住一些成功的经历,每当遇到一个新情景时,我们会从记忆中搜索过去遇到过的相似经历,根据当时成功的策略来做出快速决策。该论文提出了一个新颖的策略学习框架,结合情景控制和强化学习,将情景记忆中有关系的经历关联起来,将独立的记忆碎片连结形成了联想记忆网,更高效地利用已有的成功经历来提高强化学习效率。具体来说,该论文基于状态转换函数进行建图,将所有记忆中的状态关联起来,并开发了一个高效的传播算法,使得值函数可以在图上进行快速更新迭代,最后利用它们更好地指导强化学习。在经典Atari游戏上的实验结果表明,该方法提高4倍以上学习效率。

11.On Generalization Error Bounds of Noisy Gradient Methods for Non-ConvexLearning. Jian Li, Xuanyuan Luo, Mingda Qiao. (Poster)

由2019级硕士生骆轩源及2018届姚班校友乔明达在我院李建副教授的指导下,共同合作完成的论文《论非凸学习下有噪声梯度方法的泛化误差上界》主要在理论上分析了若干学习算法的泛化能力。泛化误差也即一个学习算法在训练集和真实未知数据集上表现的差距,是机器学习理论最重要的问题之一。基于该文新提出Bayes-Stability理论框架,作者得到了比前人更优的SGLD的期望泛化误差上界O(G/n),其中G和n分别是训练路径上梯度的范数之和以及训练集大小。同时该上界对于非高斯噪音、动量加速、和滑动平均等扩展情况一样成立。除此之外,该文还证明了连续时间朗之万运动(CLD)任意时刻的Log-Sobolev不等式,基于该结论,作者证明了在加入了l2正则化之后,CLD的期望泛化误差以O(1/n)的速度减小,并且该上界可以与训练时间无关。

(文/孙帅)