她说,要穿越多元文化,做独具特色的科研。“她在发现重要的研究问题上很有品位。她已经对该领域产生了非凡的影响,并且她的影响只会越来越大。”斯坦福大学语言学和计算机科学教授、自然语言处理泰斗 Dan Jurafsky 曾这样评价她。她是2012届姚班校友,陈丹琦。

嘉宾简介

陈丹琦,2012届姚班校友,现任普林斯顿大学计算机科学系助理教授,普林斯顿NLP团队共同带头人。她的研究专注于自然语言处理的深度学习,尤其是在文本理解与知识表示和推理的交叉,问答系统、信息提取和会话系统中的应用。加入普林斯顿大学之前,陈丹琦曾在西雅图的Facebook AI 研究中心担任访问学者。她曾获2019年斯坦福大学Arthur Samuel最佳博士论文奖,Facebook奖学金,微软女性研究奖学金以及ACL’16和EMNLP’17的论文奖。

01 弱水三千,只取一瓢

您的博士论文这么受欢迎,您是如何挖掘到这些有趣、重要的问题呢?

所有的科研都是有一定契机的。包括我现在上课教论文的时候,不可能孤立地教授一篇论文,它一定是有铺垫的。我从12年开始读博,到今天为止,过去8、9年 AI 这个领域已经发生了天翻地覆的变化,有很多革命性的东西都在这些年出现。首先你要知道什么样的问题是最前沿的。然后真的需要一些契机,需要很多的思考,需要知道当前大家最关心的是什么问题,什么问题是重要的。当然除了契机,也需要对自己的领域有非常深刻的理解,以及一点运气和其他的东西,例如你做出东西之后如何跟人有效地交流,如何让你的工作被更多人知道,这个东西以后怎样让别人去跟进。这些都是需要充分的努力之后才能把你工作推出去的。

您是怎样发现这个“契机”的呢?

首先我得确认这个问题是重要的。其实,有个故事我很少去讲。博士第二年,我写了一篇论文(我是博士第一年结束才加入Stanford NLP group的),也是我的第一篇NLP领域的论文A Fast and Accurate Dependency Parser using Neural Networks。那篇论文非常有名,就是那一篇论文让我们领域的很多人都认识了我,现在基本上所有教科书都会提及。这篇文章讲述的是parsing问题,就是说给定一个句子,然后计算它的一个句法结构,这在NLP里是非常基础性的一个问题。

我想讲的故事是,因为那个东西成功了,到我博士第三年的时候,我就想做很多它周边的东西,包括 cross-lingual parsing,multi-lingual parsing等。这一年我感到压力很大,因为我做不动。我导师是一个语言学家,他很懂这个东西,但是我对除了英语和中文,其他语言的理解非常的浅 (我的第一篇文章做的是英文和中文)。他们当时在推universal dependencies,即怎么样做一个句法的范式使其对很多语言都能应用。他们在努力地做这方面的研究,也希望我继续把这个发扬。但是我不懂其他语言,那时候我的语言学背景非常差,然后就做得非常挣扎。我做的实验结果都很好,我知道写成论文一定能发,但是最后我自己选择没有投稿。因为我不知道这个实验结果到底能否真正的证明我们的方法有效,它到底是因为方法本身呢,而是因为不同语言的数据收集方式或者范式不同呢? 我不知道我能给我们领域带来什么新的视角。总之就在那一年,我特别挣扎,从那时候起,我开始思考,什么东西对我来说是我相信的且真正有用的。我想要找到能真正让我激动的问题,而不是为了去发论文,为了去追求一些论文数什么的而去做研究。所以第三年的时候就开始去想 reading comprehension 这个问题。那时候这个问题还不太存在,我们甚至不知道如何去定义它。我当时就相信,我们有这么多语言学的知识和任务,Reading Comprehension 是一个综合的、有意义的任务,能够去度量计算机理解语言的能力。就是在这个契机中,我看到了 reading comprehension 的潜力。

这是我的故事,总的来说,我想说的点是找问题是最关键的,而且是要你自己去找,不是别人告诉你哪个问题重要。不是你的老板告诉你做什么你就做什么。这对低年级的博士生可以,但是最终你要成长为一个独立的研究者,所以你发现问题的时间,可能比解决问题的时间要长得多。我最开始做 parsing 时完全不懂 parsing,因为这是我老板给我的项目。但是到我博士研究的后期,以及现在我对自己的学生,都要求他们必须要有自己寻找问题的能力。我想提一个人 Andrej Karpathy,他是李飞飞的学生,他有一个文章 《A Survival Guide to a PhD》,这篇文章写得好非常好,我向你们强烈推荐。

02 沉舟侧畔千帆过

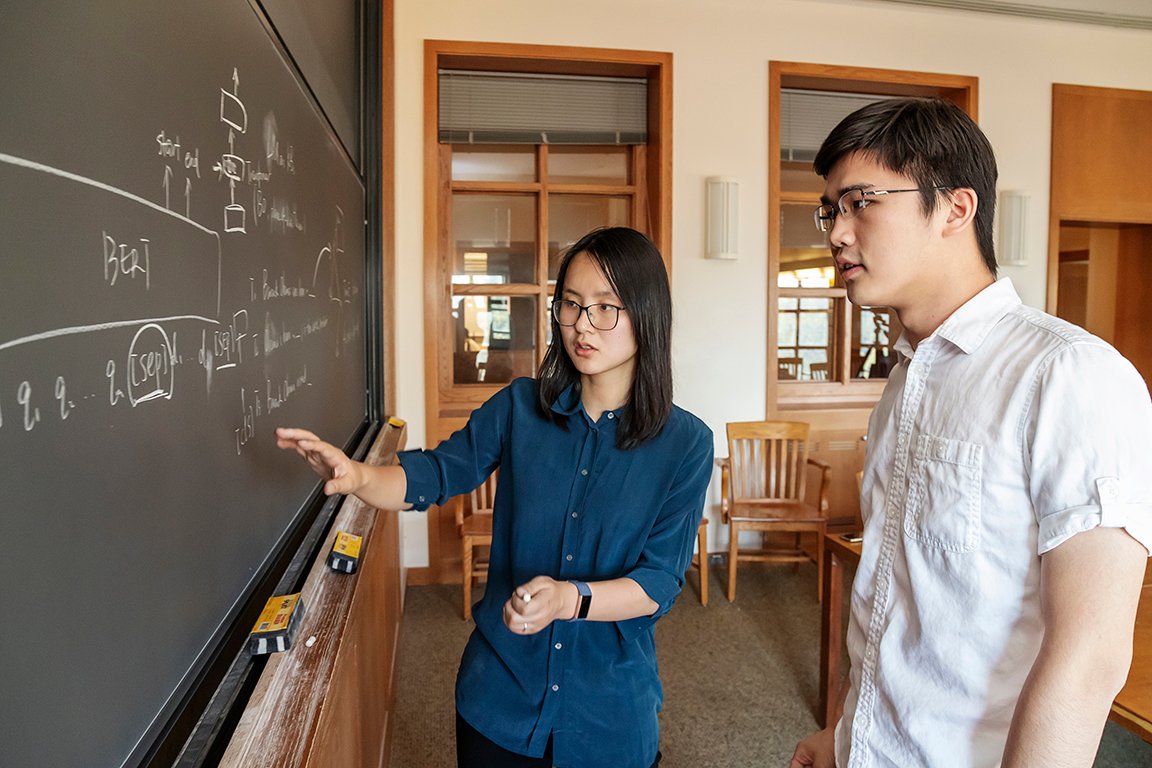

请分享一些您最近的研究吧?

我现在比较关注的有三个大方向。第一个方向是knowledge-intensive NLP以及knowledge retrieval的问题,这里我们关心知识和语言怎么表示。比如说给出 Wikipedia 的文档,我们如何把知识处理和保存起来。当你有一个询问的时候,我们怎么把知识抓取出来做回答或者帮助其他的NLP问题。

第二个是 NLP 模型训练里的 efficiency 问题,在 BERT、GPT-3 火起来之后,NLP 进入了一种 pretraining 和 fine-tuning 的范例,但是这里有一个问题就是这些模型往往巨大无比。我很关心怎么设计算法让模型变得更小、训练更快,同时使它们在更少的数据下把任务做好。

第三个是泛化问题。这里我们关心一个模型它在一个问题上训练完之后怎么泛化到别的问题上。这个问题现在根本解决不了,目前有的结果太差了。我认为这是一个很大的问题,虽然有很多数学上很漂亮的解法,但是它们的表现都不理想。

请分享一两个您最近比较关心的工作?

一个是 DensePhrases (Learning Dense Representations of Phrases at Scale),这篇文章还在审稿中。这里我们想做一个 phrase embeddings的一个索引。考虑这样一个场景:给定一个问题,我怎样找到答案?传统的解法是先让模型找到相关的文档,然后再读一遍这些文档来找到答案,这是以前的一个解法,这也是我 PhD 期间做的一个work。这篇文章的一个新想法是,我们现在不需要去读每个文档了,我有办法把大量的 Phrases 都用低维的向量去表示,然后来做索引,这不止可以做问答,还可以把Phrase向量当成一个knowledge base,这样我就可以直接从Phrase层次去获取有关信息。这是我挺关心的一个方向,我们这篇文章只是一个阶段性结果,我们还在继续深挖。

还有一个工作是我和我的博士生Tianyu Gao (也是清华毕业)以及另外一个MIT博士生Adam Fisch做的 Making Pre-trained Language Models Better Few-shot Learners,也是在审稿中。在 GPT-3 之后,大家都知道这样一个很大的模型你可以给它一个 prompt,给它大概 32 个输入例子,它就能直接给出答案。这里我们关心的是给模型 32 个例子,我们怎么能训练一个更好的 classifier 来做这些问题。我们这篇文章提出了几个解法,而且我们做的不是 GPT-3 这样千亿规模的,我们做的是 BERT、RoBERTa 这样只有百万级别的参数。这个东西我们也在继续思考,我认为它的潜力很大。

怎么看待人工智能和机器学习的大热呢?

这是一个很幸运,也很不幸的时代 (笑)。首先有越来越多的人去做这个领域,从整个领域的角度来看,它会发展得越来越快。但是同时,想要让你的工作被人记住以及做真正有影响力的工作的难度也越来越大。我有时在想我们领域的文章每年增长 50% 到 1倍,但是我们真的有那么多值得解决的问题吗?如果我们的问题的space在增大那也可以,但是我觉得现在每年一两千篇文章的情况,解决的还是那些有限的问题,这便是一个不太好的现象。

另一方面就是这么多学生,这么多学者在做同一个领域,会让审稿过程变得很困难,有的审稿者可能难以客观地评价一个工作。很多人非常关注论文数,但是现在的审稿结果并不完美。你只能依靠一些可靠的 Area Chairs 去把控审稿质量,但是 Area Chair 这个池子也很大。我说得可能比较消极,有很多人包括我自己在努力改变这个事情,但是确实很难,这中间存在太多的问题与竞争了。

我也说一点积极的方面,首先有那么多学生想做我们的领域,我们的学生越来越好,有越来越多很强的人在里面,这个领域的发展也会越快,如果一个领域太小没有人做也会是一个问题。从研究基金的角度看,也是在往好的方向发展。因为大家关心这些问题,所以我们也有很多钱去支持更多学生,办会议等等。

03 万水千山,不忘来时路

说说您的茶园记忆吧?

首先我觉得我们当年所在的交叉信息院(简称叉院)和你们现在的叉院肯定是很不一样的。交叉信息院是在我们大三那一年成立的。我们在前两年上了特别多的课。当时的姚课,对我们来说很新鲜。当时姚班的一些同学会去上高一届学生的课(尤其是班里比较top的同学前两年就修掉了大部分的课程),这给学长学姐们很多压力。那时我也做ACM竞赛,在我印象中前两年特别忙碌,要上很多课,作业考试都不能耽误。犹记得曾在在火车上做作业的情景,现在依然映像深刻。当时没有春研的机会,现在大家比我们那时多了不少出去交流的机会。总的来说,你周围的这些同学都是非常强的,他们到了美国之后也做得很好。姚班的课程,学习上的挑战给我们打下了夯实的基础,让我们有能力也更愿意去解决一些更难更有挑战性的问题。

对茶园学弟学妹的嘱咐

本科生的时候要先把基础打好,不用太追求发很多paper。把基础打牢,如果本科能有一个让你很高兴的工作就是很好的事情。此外,这个世界变化是很快的,你也无法预测这个领域接下来怎么发展,所以要尽可能多学,尽可能拓宽知识面。还有就是格局的问题,格局可能就是要接触更多的人,更多的事,你才能了解什么是最顶尖最前沿的,这个能力需要慢慢发展。我建议大家要尽可能去各个地方实习,接触不同的人,去了解他们的工作,去了解别人的思维模式和他们所在领域最关心的问题。只有通过广泛的交流才能找到自己的位置。我的合作者有很多不同国家背景的人,每个人的优势非常不一样,在跟他们合作中真的可以学到很多东西。太多中国学生抱团可能不是太好的一件事,你们的背景是相似的,所以上手合作可能更容易,更快,说话沟通的方式更简单,但是你们可能并不能扬长补短,因为你们的长处都相似。比如清华的学生可能编程和数学都比较好,大家的优势都比较相似。但是我认识很多以色列、欧洲的人,他们做 NLP 的风格都非常不一样。我觉得有一个文化背景更多元的群体还是更好的一件事。对于科研品味来说,不跟风是永远正确的。但是我知道在这个大环境下很难很难。因为现在太多人过于在意论文发表数目。比如说一年就2、3个ddl,相邻ddl之间就隔了3、4个月,如果你的目标是赶上下个ddl你能赶上,那么跟风是很难避免的。我觉得这是非常不好的,每个人都要找到自己心中那杆秤,怎么去平衡这件事情。我在 Stanford 读书的时候,我们被告诉的事情是读博士只需要有 3篇论文,这 3篇论文要求是连续递进的,能够铺垫一个领域,并且这些工作要能被人知道。但是现在一个本科生申请的时候,很可能就已经有 7、8 篇论文。然而这个现象是不会改变的:尤其是当你找教职工作时,或者被你领域里的人认识,一定是靠你的代表作,而不是你有多少篇论文。如果你只是跟风,做一些 incremental 的问题,这样的工作是很难被人知道的,尤其是在现在一年一两千篇论文的环境下。

对茶园的祝福

首先我非常感谢姚班,我一直很为此骄傲。姚班给我们创造了一个平台让我能去 Stanford这样的学府深造。如果没有姚班我不可能去 Stanford 读 PhD,也就不会接触到后面这些事情。姚班出了很多很牛的人,姚班的国际国内影响力与日俱增。最后我想说 The future is bright (笑) 。

《从茶园走向世界》校友访谈组成员:朱追、邱子涵、温凯越、吕欣、谢琴