交叉信息院智班本科生景彦森(智90)、陈醉(智90)同学共同合作的项目Sound2Synth:自动预测合成器参数的多模态模型荣获清华大学第四十届“挑战杯”信息技术赛道一等奖。

当音乐遇上AI

音乐是时间的艺术,在音色、音调和节奏的交叉律动下,直指人们的心灵。穿越春秋冬夏,来到元宇宙时代,当音乐遇上人工智能又会擦出什么样的火花?

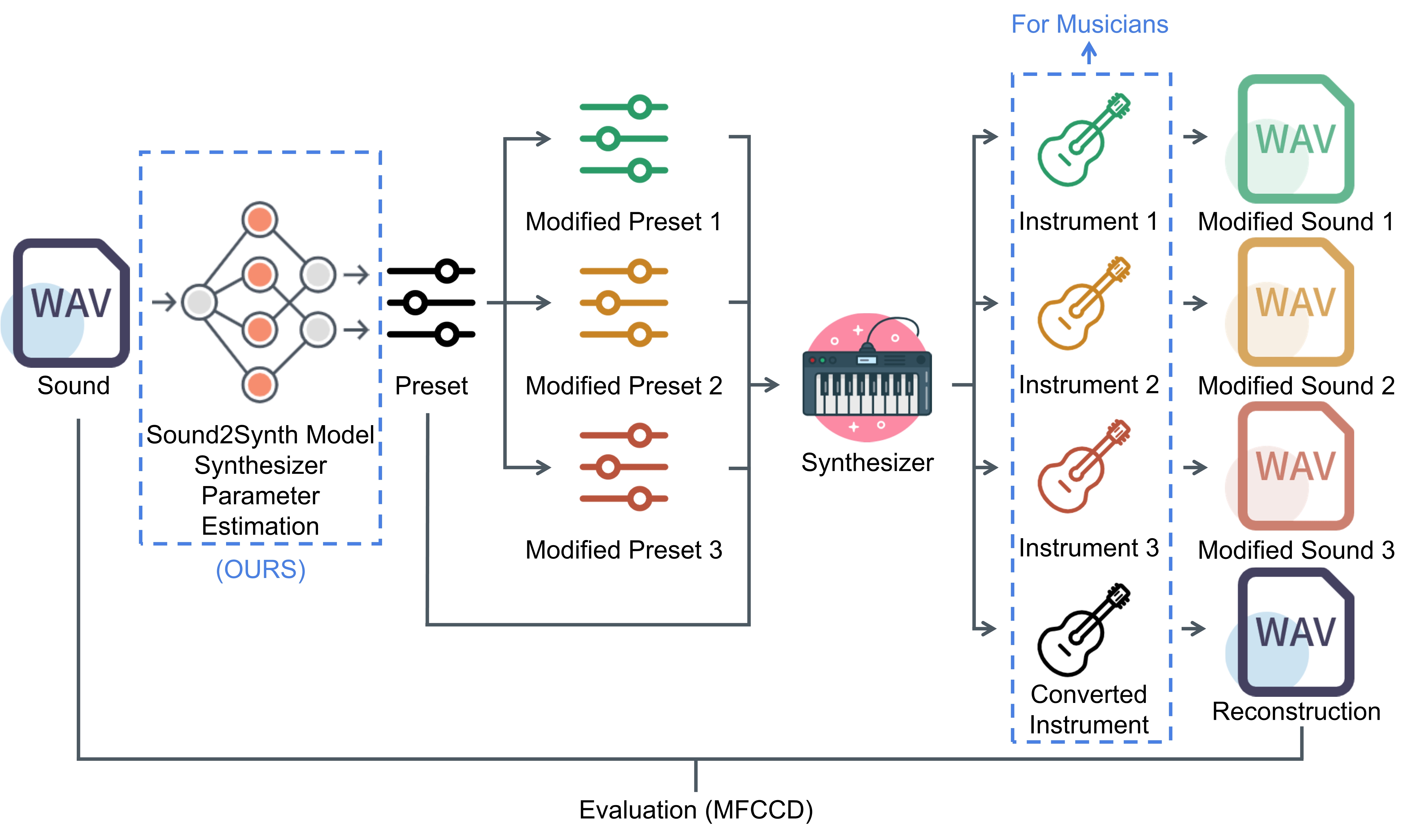

想要将鸟叫声做成一首音乐?想要为一部科幻电影配乐?想要定制一把异域风情的吉他?你需要一个合成器。合成器是一种通过算法生成音频波形的电子乐器:每次传入一组不同的参数,就会得到一个不同的乐器。然而,究竟哪几组参数对应鸟叫声、科幻音效、吉他呢?为合成器找到合适的参数是一个复杂的课题——电子音色设计,而这往往需要音乐工作者经过数年学习积累、熟练使用合成器。Sound2Synth旨在使用神经网络将一段音频自动转化为合成器参数,进而得到比原音频更加灵活可调节的乐器,可以显著简化音乐工作者的工作流程。除此之外,合成器参数估计问题在现代音乐工业中也有其他十分重要的应用,例如音频压缩、合成器评估等。

流程方面,景彦森和陈醉同学使用监督学习方法,将合成器参数估计问题转化为多标签分类问题进行训练。合成器参数十分庞大复杂 (例如Dexed合成器有155个参数,包括连续和离散参数),他们提出了参数离散化、参数平滑、梯度启发权重等技巧改进了训练过程。

模型方面,两位同学使用了多模态模型,用不同的网络结构处理不同模态的音频信息,并针对CQT频谱图提出了原创模型结构质数膨胀卷积网络 (PDCNN, Prime-Dilated CNN)。

实现方面,他们自己搭建了一套远程数据集预处理、训练、测试、音频渲染、插件运行框架,兼顾真实音乐工业使用场景和个人用户使用场景。

他们的初心

景彦森:“在交叉信息院本科生这个身份之外,我同时还是一名业余电子音乐制作人。音乐的本质是声波函数的变换与叠加。从傅里叶分解的角度来看,每一首音乐作品本质上是都是若干正弦函数运算的结果。在合成器等电子音乐设备出现之前,人们获得和处理声波函数的工具十分有限。电子音乐设备的出现,极大的扩展了我们可以利用的波函数的范围。合成器的内部原理涉及到非常复杂的信号处理的算法。作为一名音乐制作人,几乎不可能完全了解市面上主流的商业合成器背后的原理,这使得利用合成器进行音色设计十分困难,几乎变成了一个在盲目尝试中碰运气的过程。然而,合成器的数学抽象则十分简单:合成器本质上是一个映射,这个映射的输入是一组参数,输出是一段音色的音频。作为智班的一名学生,我和陈醉同学很自然地想到:我们能否用深度神经网络来学习这个映射?这就是我们这个项目最初的动机。”

陈醉:“我在音乐制作过程中接触到合成器,发现自己做合成器调参工作比较困难,而参数预置则有很多,也有市场。我个人比较喜欢史诗音乐,在合成器这方面我不如做电子音乐的景彦森同学了解的多,于是就找他说了这个想法。当时他也觉得很有意思,我们就趁着暑期一起研究了这个想法,并且联系了一些学长、老师,最终合作将这件事逐步完成。因为都是智班的同学,也都是音乐爱好者,当初做项目最开始就是想到可以把专业与爱好,AI与音乐相结合。接下来我们希望继续在这个方向上做改进,完善目前的研究结果,目标是最后能落地推广成为一个让很多音乐人可以使用、喜欢使用的软件。”

景彦森、陈醉同学的兴趣缘起于人工智能交叉项目。人工智能交叉项目课程是交叉信息研究院人工智能实验班(智班)的核心课程,旨在引导同学们使用人工智能技术解决交叉领域的实际问题。本课程提供了丰富的项目主题以满足学生们多样的需求。在本年度课程中,项目主题涵盖医疗、法律、建筑、金融、音乐、经济等多个领域。景彦森、陈醉同学在交叉信息院助理教授赵行的指导下,以共同第一作者将研究成果发表在AI领域顶级会议IJCAI2022上(International Joint Conferences on Artificial Intelligence)。

论文链接:

https://arxiv.org/abs/2205.03043