2022年国际计算机视觉与模式识别会议即将于6月19日至6月24日在美国路易斯安那州新奥尔良市举行。交叉信息院多个课题组共有14篇论文入选,在三维场景理解、三维深度学习、几何分析等多个领域取得重要进展。

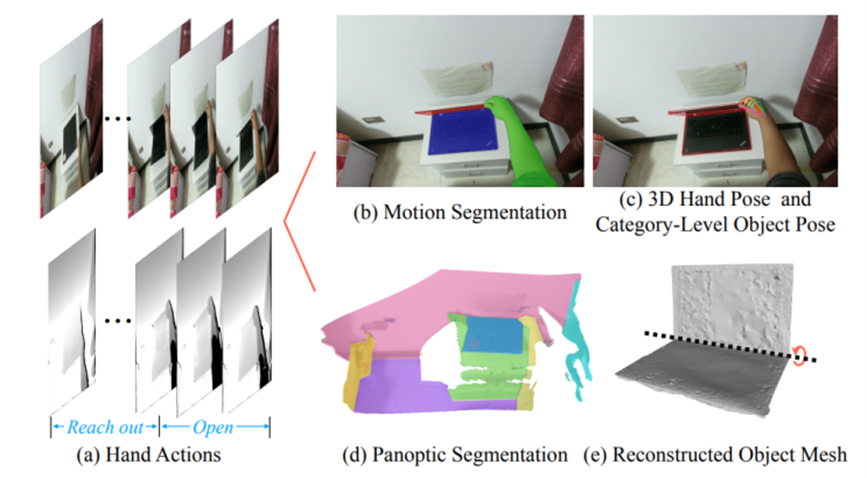

HOI4D:第一人称下的类别级人-物交互的4D数据集

得益于大量数据集和基准任务的提出,如何在图片、视频和点云中感知物体和人类活动这一问题已经取得了显著的成果。但是,随着机器人行业的快速发展和元宇宙的兴起,仅对上述数据类型进行感知已经无法满足行业的需求。机器人和VR/AR设备可以产生大量的4D数据(第一人称下的彩色点云序列), AI系统需要从中理解语义信息、手和物体的位姿信息、物体的功能性以及人手动作的类别等,这都是非常具有挑战性的开放问题。

大规模第一人称视角下以人-物交互为核心的四维点云视频数据集HOI4D总览

课题组在论文中提出了第一个大规模第一人称类别级人-物体交互4D数据集HOI4D。HOI4D提供了用于全景分割、运动分割、3D手部位姿、类别级物体位姿和手部动作的逐帧注释,以及物体CAD模型和重建场景点云。论文还建立了三个基准任务来促进4D类别级人-物体交互的发展,包括 4D 动态点云序列的语义分割、类别级物体位姿跟踪和第一人称的细粒度视频动作分割。此研究可以支持大量的新兴研究方向,如4D场景理解,类别级人-物体交互,动态场景重建等,对人-物体交互领域的发展具有重要推动作用。

论文作者:交叉信息院2022级博士生刘昀泽、2022级博士生刘昀、交叉信息院2019级本科生吕康博、交叉信息院助理教授弋力,以及其他作者。

论文链接:https://arxiv.org/pdf/2203.01577.pdf

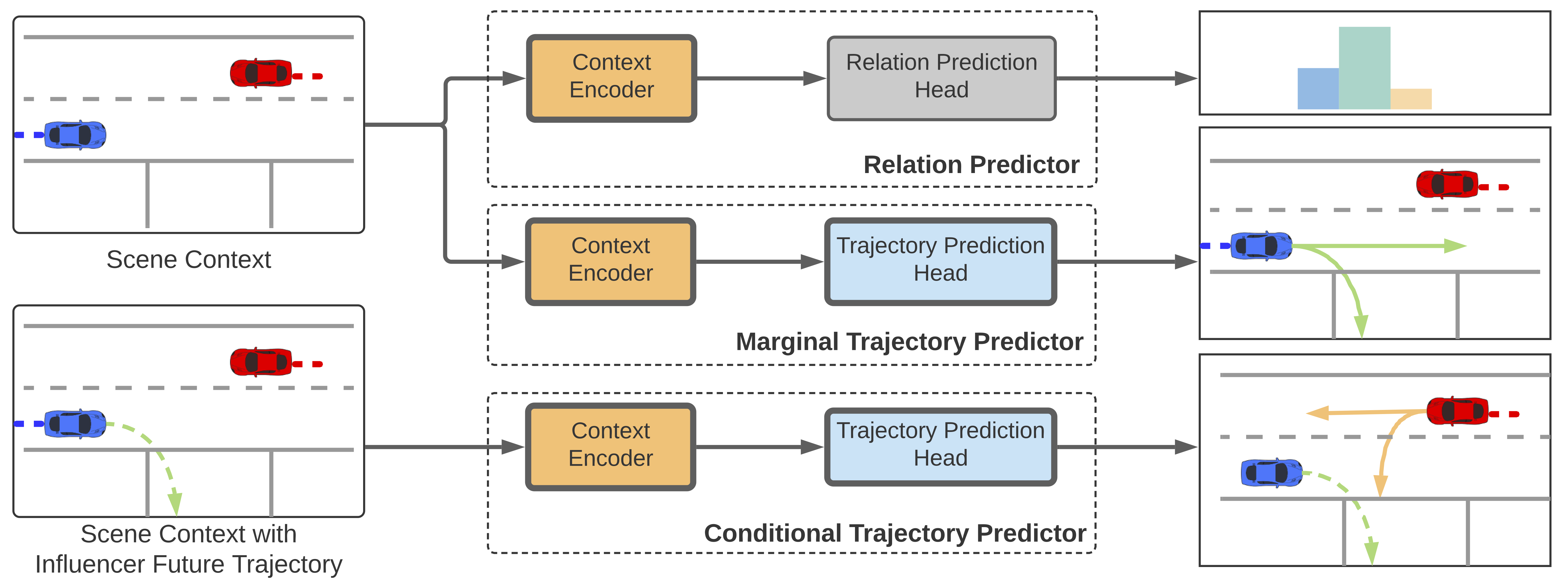

用关系预测解决交互场景中的轨迹预测问题

轨迹预测是自动驾驶系统中的重要模块,预测结果一般被用于下游的规划系统来避免自动驾驶车辆与其他车辆或行人发生碰撞。近年来,相关研究大多使用真实路况采集的大型数据集来训练深度学习模型来完成轨迹预测。这些方法在预测多车轨迹时,通常是每辆车单独预测,预测结果中的轨迹会出现互相交叉等不真实的情况从而损害场景级别上的预测精度。

“M2I”轨迹预测框架

该研究提出了一种新的利用关系预测的轨迹预测的方法“M2I”。该方法首先预测场景中车辆之间的关系,然后通过先预测先行一方未来的轨迹,再用该预测结果预测让行一方轨迹的方法得到双方的联合预测结果。实验表明通过引入关系预测可以获得比其他方法在场景级别上更合理,也更准确的轨迹预测结果。

论文作者:交叉信息院2022级拟入学博士生孙桥、交叉信息院2021级博士生辜俊儒、交叉信息研究院助理教授赵行。

论文链接:https://arxiv.org/abs/2202.11884

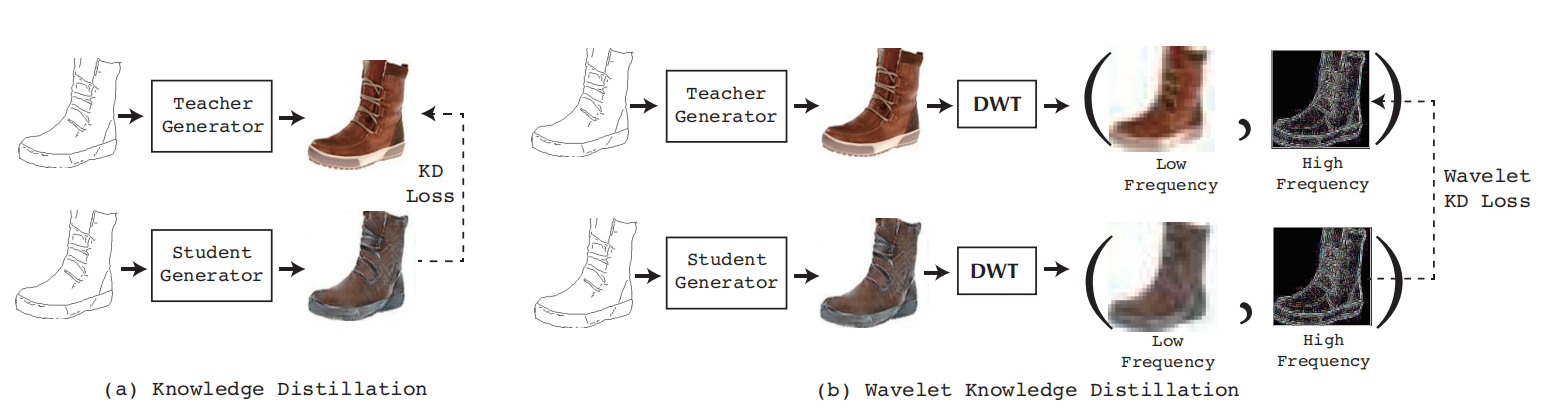

通过小波知识蒸馏实现高效的图像翻译

近年来,随着对抗生成神经网络的发展,图像到图像翻译任务的性能取得了不断的突破,并在许多现实世界应用中得到部署,例如各类直播软件中的美颜功能、图像动漫化功能等。然而,由于对抗生成神经网络往往具有海量的计算量和参数量,这些模型的计算速度较慢,无法实时的在手机等边缘设备上运行,限制了这一技术的广泛应用。

传统知识蒸馏算法(左图)与研究者所提出方法(右图)的对比

为解决这一问题,研究团队提出了一种基于离散小波变换的知识蒸馏算法,对图像到图像翻译模型进行压缩。他们研究发现,较大的图像翻译模型和较小的图像翻译模型对于图像的低频信息部分都有比较好的生成效果。与大模型相比,小的图像翻译模型在高频信息的生成上表现不佳。因此,他们以高频信息为切入点,通过离散小波变换提取不同模型在高频信息的生成结果,通过知识蒸馏的方式提高小模型在高频信息上的表现。

论文作者:交叉信息院2019级博士生张林峰、交叉信息院助理教授马恺声。

论文链接:https://openaccess.thecvf.com/content/CVPR2022/html/Zhang_Wavelet_Knowledge_Distillation_Towards_Efficient_Image-to-Image_Translation_CVPR_2022_paper.html

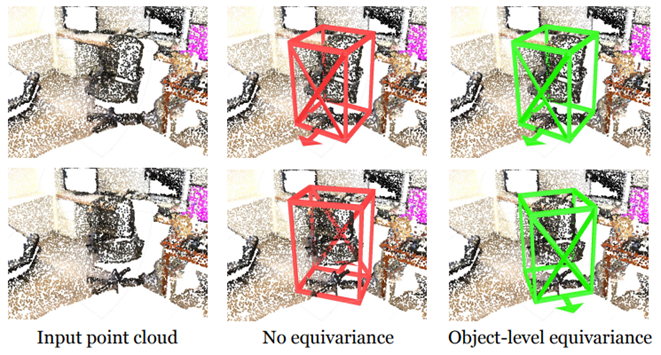

旋转等变的3D物体检测

3D目标检测在VR/AR、自动驾驶和机器人领域中都是一个基础问题。虽然已经有大量的方法被证明是有效的,但其均没有显示的对旋转等变性进行建模。物体的旋转等变性体现在物体形状的不变性和物体朝向的等变性,这要求无论输入的场景如何旋转,目标检测的结果应该保持原有形状的同时对齐其朝向。对这一问题的显示建模不仅可以避免复杂的数据增强策略,还可以在不显著增加模型参数的同时提高检测模型的表达能力和判别能力。

课题组在论文中提出了使用EON网络来提取具有局部物体级旋转等变性的几何特征,同时不丢失物体之间的上下文信息。由于大多数 3D 检测网络以分层方式提取特征,其中早期阶段专注于局部特征,而后期阶段则涵盖更多上下文级别的信息,本文提出仅在早期阶段计算等变特征,这使得旋转等变特征具有局部的空间支持。为了在不破坏局部旋转等变性的前提下整合上下文信息,EON网络将每个等变特征分解为方向信息和形状信息,仅在形状信息的基础上进行上下文信息提取。

EON为具有物体级旋转等变特性的三维物体检测技术

论文在室内场景和自动驾驶数据集上进行实验,将EON设计插入先进的3D目标检测器,可以获得显着的性能提升。这一研究将旋转等变神经网络推广到场景理解任务中,为3D骨干网络的设计提供了新的思路。

论文作者:交叉信息院助理教授弋力、交叉信息院2014届姚班校友、斯坦福大学助理教授学吴佳俊以及斯坦福大学计算机系博士二年级学生俞洪兴。

论文链接:https://arxiv.org/pdf/2204.13630.pdf

关于CVPR

CVPR全称IEEE国际计算机视觉与模式识别会议(IEEE Conference on Computer Vision and Pattern Recognition),该会议始于1983年,是计算机视觉和模式识别领域的顶级会议。